Огляд статистичних та нейронних методів сегментації рядків для задачі офлайн розпізнавання рукописного введення

DOI:

https://doi.org/10.15587/2706-5448.2024.298405Ключові слова:

сегментація рядків рукописного тексту, розбиття на лінії, знаходження тексту, алгоритми розпізнавання, глибокі нейронні мережіАнотація

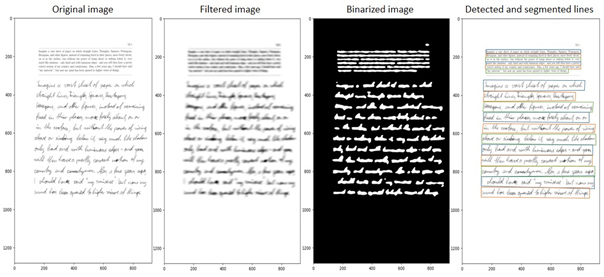

Об’єктом дослідження є задача сегментації рядків рукописного тексту. Для розпізнавання рукописного тексту в документах, що мають формат зображень, застосовується технологія офлайн розпізнавання рукописного тексту. Модуль розпізнавання тексту приймає на вхід окремі рядки тексту, тому одним з важливих етапів попередньої обробки даних є знаходження та розбиття рукописного тексту на окремі лінії.

В роботі досліджується задача сегментації рядків рукописного тексту, вимоги до неї, існуючі проблеми та виклики. Було розглянуто два основні підходи до цієї задачі, що застосовується в сучасних системах розпізнавання, а саме: статистичні методи на основі проекцій та методи на основі нейронних мереж. По кожному з підходів проведено огляд сучасних робіт та досліджень. Описано основні принципи запропонованих методів, проведено аналіз їх сильних і слабких сторін, з врахуванням поставлених задач, обмежень та особливостей вхідних даних. Загальні отримані результати сформовано в спільну таблицю для порівняння методів між собою.

Базуючись на останніх роботах, що застосовують глибокі нейронні мережі, визначено нові можливості використання цих методів в системах розпізнавання, що були недоступні з традиційними статистичними підходами сегментації тексту.

На основі проведеного дослідження сформовано конструктивні висновки, що описують основні переваги та недоліки кожного з підходів до сегментації рукописного тексту. Ці результати можуть бути надалі використані для правильного вибору підходящих методів у системи розпізнавання рукописного тексту для покращення продуктивності та якості їх роботи, а також для подальших досліджень в цій області.

Посилання

- Sumi, T., Kenji Iwana, B., Hayashi, H., Uchida, S. (2019). Modality Conversion of Handwritten Patterns by Cross Variational Autoencoders. Computer Vision and Pattern Recognition. doi: https://doi.org/10.48550/arXiv.1906.06142

- Volkova, V., Deriuga, I., Osadchyi, V., Radyvonenko, O. (2018). Improvement of Character Segmentation Using Recurrent Neural Networks and Dynamic Programming. 2018 IEEE Second International Conference on Data Stream Mining & Processing (DSMP), 218–222. doi: https://doi.org/10.1109/dsmp.2018.8478457

- Omayio, E. O., Sreedevi, I., Panda, J. (2022). Word Segmentation by Component Tracing and Association (CTA) Technique. Journal of Engineering Research. doi: https://doi.org/10.36909/jer.15207

- Gruning, T., Labahn, R., Diem, M., Kleber, F., Fiel, S. (2018). READ-BAD: A New Dataset and Evaluation Scheme for Baseline Detection in Archival Documents. 2018 13th IAPR International Workshop on Document Analysis Systems (DAS). Vienna, 351–356. doi: https://doi.org/10.1109/das.2018.38

- Moysset, B., Kermorvant, C., Wolf, C., Louradour, J. (2015). Paragraph text segmentation into lines with Recurrent Neural Networks. 2015 13th International Conference on Document Analysis and Recognition (ICDAR), 456–460. doi: https://doi.org/10.1109/icdar.2015.7333803

- Vo, Q. N., Lee, G. (2016). Dense prediction for text line segmentation in handwritten document images. 2016 IEEE International Conference on Image Processing (ICIP), 3264–3268. doi: https://doi.org/10.1109/icip.2016.7532963

- Yakovchuk, O., Cherneha, A., Zhelezniakov, D., Zaytsev, V. (2020). Methods for Lines and Matrices Segmentation in RNN-based Online Handwriting Mathematical Expression Recognition Systems. 2020 IEEE Third International Conference on Data Stream Mining & Processing (DSMP). doi: https://doi.org/10.1109/dsmp47368.2020.9204273

- Razak, Z., Zulkiflee, K., Idris, M., Tamil, E., Noor, M., Salleh, R. et al. (2007). Off-line handwriting text line segmentation: A review. International Journal of Computer Science and Network Security, 8 (7), 12–20.

- Arivazhagan, M., Srinivasan, H., Srihari, S. (2007). A statistical approach to line segmentation in handwritten documents. Document Recognition and Retrieval XIV. doi: https://doi.org/10.1117/12.704538

- Ptak, R., Żygadło, B., Unold, O. (2017). Projection–Based Text Line Segmentation with a Variable Threshold. International Journal of Applied Mathematics and Computer Science, 27 (1), 195–206. doi: https://doi.org/10.1515/amcs-2017-0014

- Renton, G., Chatelain, C., Adam, S., Kermorvant, C., Paquet, T. (2017). Handwritten Text Line Segmentation Using Fully Convolutional Network. 2017 14th IAPR International Conference on Document Analysis and Recognition (ICDAR), 5–9. doi: https://doi.org/10.1109/icdar.2017.321

- Zhang, Z., Zhang, C., Shen, W., Yao, C., Liu, W., Bai, X. (2016). Multi-oriented Text Detection with Fully Convolutional Networks. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 4159–4167. doi: https://doi.org/10.1109/cvpr.2016.451

- Liao, M., Wan, Z., Yao, C., Chen, K., Bai, X. (2020). Real-Time Scene Text Detection with Differentiable Binarization. Proceedings of the AAAI Conference on Artificial Intelligence, 34 (7), 11474–11481. doi: https://doi.org/10.1609/aaai.v34i07.6812

- Xu, Y., Yin, X., Huang, K., Hao, H. W. (2013). Robust Text Detection in Natural Scene Images. IEEE Transactions on Pattern Analysis and Machine Intelligence, 36 (5), 970–983. doi: https://doi.org/10.1109/tpami.2013.182

##submission.downloads##

Опубліковано

Як цитувати

Номер

Розділ

Ліцензія

Авторське право (c) 2024 Oleg Yakovchuk, Walery Rogoza

Ця робота ліцензується відповідно до Creative Commons Attribution 4.0 International License.

Закріплення та умови передачі авторських прав (ідентифікація авторства) здійснюється у Ліцензійному договорі. Зокрема, автори залишають за собою право на авторство свого рукопису та передають журналу право першої публікації цієї роботи на умовах ліцензії Creative Commons CC BY. При цьому вони мають право укладати самостійно додаткові угоди, що стосуються неексклюзивного поширення роботи у тому вигляді, в якому вона була опублікована цим журналом, але за умови збереження посилання на першу публікацію статті в цьому журналі.