Оцінка ефективності детектора голосової активності на основі різних нейронних мереж

DOI:

https://doi.org/10.15587/1729-4061.2025.321659Ключові слова:

згорткова нейронна мережа, рекурентна нейронна мережа, детектор голосової активностіАнотація

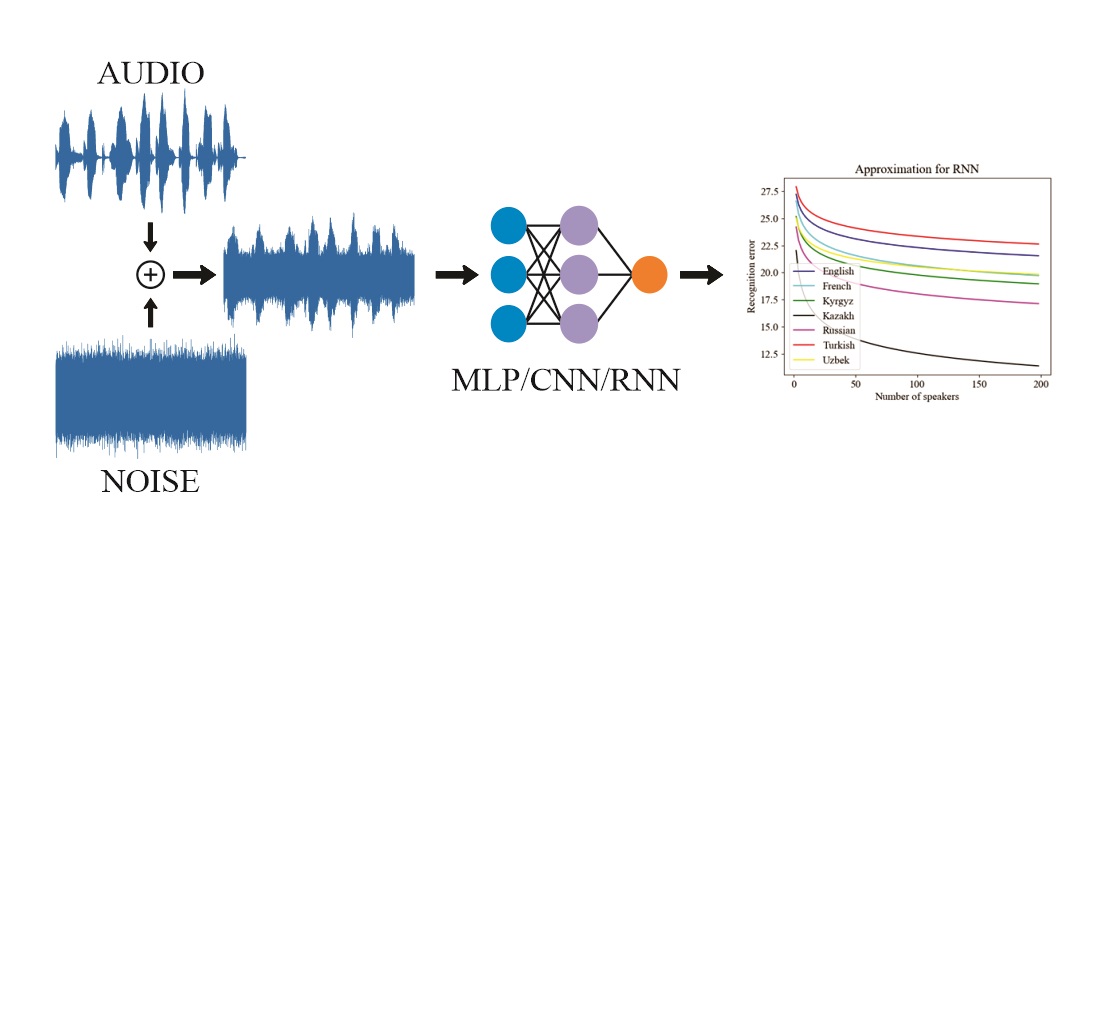

У цій роботі було проведено оцінку ефективності застосування нейронних мереж для задачі розпізнавання людського голосу. Об'єктами дослідження є штучні нейронні мережі, що використовуються для розпізнавання людського голосу. Розглядається їх здатність ефективно розпізнавати людський голос незалежно від мови, навчаючись на невеликій кількості дикторів в умовах шуму.

Розв'язувана проблема – підвищення точності виявлення мовленнєвої активності, що відіграє значну роль у вдосконаленні функціонування систем автоматичного розпізнавання мовлення, особливо в умовах низького співвідношення сигнал/шум.

Отримані результати показали, що точність розпізнавання людського голосу на мовах із різною фонетичною подібністю може суттєво відрізнятися. У результаті дослідження виявлено, що рекурентна нейронна мережа (RNN) демонструє високу точність у розпізнаванні голосу – 95 %, що перевершує результати згорткової нейронної мережі (CNN), яка досягає точності 94 %. Особливості отриманих результатів полягають в адаптації нейронних мереж до багатомовних особливостей, що дозволило підвищити ефективність їхньої роботи.

Важливим висновком стало те, що навчання нейронних мереж на даних із різними мовами та типами дикторів суттєво покращує точність розпізнавання. Дослідження підтвердило, що навчання нейронних мереж на різних мовах і типах дикторів може значно вплинути на точність розпізнавання. Отримані результати є важливим внеском у розвиток технологій розпізнавання мовлення та мають потенціал для застосування в різних сферах, де потрібна висока точність у розпізнаванні людського голосу

Посилання

- Dhouib, A., Othman, A., El Ghoul, O., Khribi, M. K., Al Sinani, A. (2022). Arabic Automatic Speech Recognition: A Systematic Literature Review. Applied Sciences, 12 (17), 8898. https://doi.org/10.3390/app12178898

- Zhang, X.-L., Xu, M. (2022). AUC optimization for deep learning-based voice activity detection. EURASIP Journal on Audio, Speech, and Music Processing, 2022 (1). https://doi.org/10.1186/s13636-022-00260-9

- Tang, M., Huang, H., Zhang, W., He, L. (2024). Phase Continuity-Aware Self-Attentive Recurrent Network with Adaptive Feature Selection for Robust VAD. ICASSP 2024 - 2024 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 11506–11510. https://doi.org/10.1109/icassp48485.2024.10446084

- Cherukuru, P., Mustafa, M. B. (2024). CNN-based noise reduction for multi-channel speech enhancement system with discrete wavelet transform (DWT) preprocessing. PeerJ Computer Science, 10, e1901. https://doi.org/10.7717/peerj-cs.1901

- Priebe, D., Ghani, B., Stowell, D. (2024). Efficient Speech Detection in Environmental Audio Using Acoustic Recognition and Knowledge Distillation. Sensors, 24 (7), 2046. https://doi.org/10.3390/s24072046

- Tan, Y., Ding, X. (2024). Heterogeneous Convolutional Recurrent Neural Network with Attention Mechanism and Feature Aggregation for Voice Activity Detection. APSIPA Transactions on Signal and Information Processing, 13 (1). https://doi.org/10.1561/116.00000158

- Mihalache, S., Burileanu, D. (2022). Using Voice Activity Detection and Deep Neural Networks with Hybrid Speech Feature Extraction for Deceptive Speech Detection. Sensors, 22 (3), 1228. https://doi.org/10.3390/s22031228

- Rho, D., Park, J., Ko, J. H. (2022). NAS-VAD: Neural Architecture Search for Voice Activity Detection. Interspeech 2022, 3754–3758. https://doi.org/10.21437/interspeech.2022-975

- Nurlankyzy, A., Akhmediyarova, A., Zhetpisbayeva, A., Namazbayev, T., Yskak, A., Yerzhan, N., Medetov, B. (2024). The dependence of the effectiveness of neural networks for recognizing human voice on language. Eastern-European Journal of Enterprise Technologies, 1 (9 (127)), 72–81. https://doi.org/10.15587/1729-4061.2024.298687

- Liu, P., Wang, Z. (2004). Voice activity detection using visual information. 2004 IEEE International Conference on Acoustics, Speech, and Signal Processing, 1, I-609–612. https://doi.org/10.1109/icassp.2004.1326059

##submission.downloads##

Опубліковано

Як цитувати

Номер

Розділ

Ліцензія

Авторське право (c) 2025 Bekbolat Medetov, Aigul Nurlankyzy, Timur Namazbayev, Aigul Kulakayeva, Ainur Akhmediyarova, Ainur Zhetpisbayeva, Nurtay Albanbay, Mussa Turdalyuly, Asset Yskak, Gulzhazira Uristimbek

Ця робота ліцензується відповідно до Creative Commons Attribution 4.0 International License.

Закріплення та умови передачі авторських прав (ідентифікація авторства) здійснюється у Ліцензійному договорі. Зокрема, автори залишають за собою право на авторство свого рукопису та передають журналу право першої публікації цієї роботи на умовах ліцензії Creative Commons CC BY. При цьому вони мають право укладати самостійно додаткові угоди, що стосуються неексклюзивного поширення роботи у тому вигляді, в якому вона була опублікована цим журналом, але за умови збереження посилання на першу публікацію статті в цьому журналі.

Ліцензійний договір – це документ, в якому автор гарантує, що володіє усіма авторськими правами на твір (рукопис, статтю, тощо).

Автори, підписуючи Ліцензійний договір з ПП «ТЕХНОЛОГІЧНИЙ ЦЕНТР», мають усі права на подальше використання свого твору за умови посилання на наше видання, в якому твір опублікований. Відповідно до умов Ліцензійного договору, Видавець ПП «ТЕХНОЛОГІЧНИЙ ЦЕНТР» не забирає ваші авторські права та отримує від авторів дозвіл на використання та розповсюдження публікації через світові наукові ресурси (власні електронні ресурси, наукометричні бази даних, репозитарії, бібліотеки тощо).

За відсутності підписаного Ліцензійного договору або за відсутністю вказаних в цьому договорі ідентифікаторів, що дають змогу ідентифікувати особу автора, редакція не має права працювати з рукописом.

Важливо пам’ятати, що існує і інший тип угоди між авторами та видавцями – коли авторські права передаються від авторів до видавця. В такому разі автори втрачають права власності на свій твір та не можуть його використовувати в будь-який спосіб.