Формалізація текстових запитів до систем штучного інтелекту

DOI:

https://doi.org/10.15587/1729-4061.2025.335473Ключові слова:

формалізація запитів, великі мовні моделі, штучний інтелект, структуровані шаблони, варгеймиАнотація

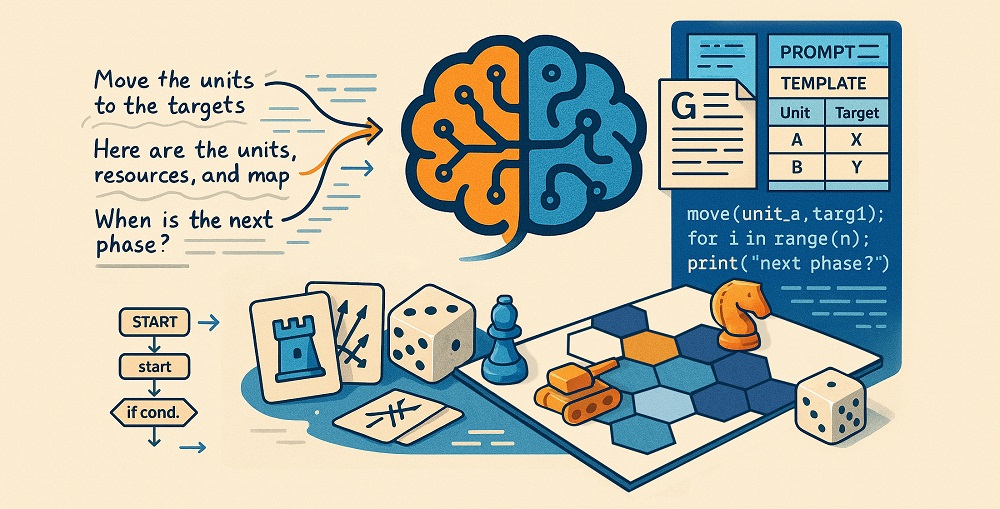

Об’єктом дослідження є процес формалізації текстових запитів до великих мовних моделей штучного інтелекту з метою автоматизованої генерації карток дій для настільних гексагональних варгеймів. Проблема полягає у надмірній неоднозначності (42% помилкових інтерпретацій термінів), контекстній неповноті (37%) та синтаксичній варіативності (21%) натуральномовних запитів, що призводить до малокорисних і непередбачуваних відповідей. Для вирішення цієї проблеми запропоновано концептуально-практичну модель, яка поєднує структуровані шаблони запитів, локалізований глосарій ключових термінів і чітку вказівку формату відповіді. Практичну апробацію проведено шляхом генерації набору карток дій для настільних варгеймів у соло-режимі за допомогою сучасних великих мовних моделей, шляхом генерації понад 100 запитів і аналізу більше ніж 300 відповідей. В результаті експерименту виявлено, що формалізовані запити знизили сумарну частку помилок на 58% та підвищили релевантність відповідей з 55–65% до 88–92%. Середній час підготовки запитів скоротився на 25–40%. Шаблони «d6-таблиць» забезпечили стабільність формату виводу у 90–95% випадках, JSON-структури – у 85–90%. Інтегрований в запит глосарій та опис структури мінімізували семантичні розбіжності та синтаксичні помилки. Особливістю запропонованих типових структур запитів є їх адаптивність до різних предметних областей завдяки використанню мови опису, специфічної для кожної з них. Результати дослідження мають практичне значення для автоматизації процесів створення ігрового контенту та можуть бути адаптовані для інших предметних областей, де важлива точність, узгодженість та структурованість відповідей мовних моделей. Запропонований cистематизований підхід сприяє автоматизації створення складного контенту із гарантованим підвищенням рівня якості та передбачуваності відповідей від великих мовних моделей

Посилання

- Poola, I. (2023). Overcoming ChatGPTs inaccuracies with Pre-Trained AI Prompt Engineering Sequencing Process. International Journal of Technology and Emerging Sciences, 3 (3), 16–19. Available at: https://www.researchgate.net/profile/Indrasen-Poola/publication/374153552_Overcoming_ChatGPTs_inaccuracies_with_Pre-Trained_AI_Prompt_Engineering_Sequencing_Process/links/65109c34c05e6d1b1c2d6ae9/Overcoming-ChatGPTs-inaccuracies-with-Pre-Trained-AI-Prompt-Engineering-Sequencing-Process.pdf

- Prompt engineering. OpenAI. Available at: https://platform.openai.com/docs/guides/text#prompt-engineering

- Diab, M., Herrera, J., Chernow, B., Chernow, B., Mao, C. (2022). Stable Diffusion Prompt Book. OpenArt. Available at: https://cdn.openart.ai/assets/Stable%20Diffusion%20Prompt%20Book%20From%20OpenArt%2011-13.pdf

- Shah, C. (2025). From Prompt Engineering to Prompt Science with Humans in the Loop. Communications of the ACM. https://doi.org/10.1145/3709599

- Kojima, T., Gu, S. S., Reid, M., Matsuo, Y., Iwasawa, Y. (2022). Large Language Models are Zero-Shot Reasoners. arXiv. https://doi.org/10.48550/arXiv.2205.11916

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N. et al. (2017). Attention Is All You Need. arXiv. https://doi.org/10.48550/arXiv.1706.03762

- Liu, P., Yuan, W., Fu, J., Jiang, Z., Hayashi, H., Neubig, G. (2023). Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing. ACM Computing Surveys, 55 (9), 1–35. https://doi.org/10.1145/3560815

- Wei, J., Zhou, D. (2022). Language Models Perform Reasoning via Chain of Thought. Google Research. Available at: https://research.google/blog/language-models-perform-reasoning-via-chain-of-thought/

- Zaghir, J., Naguib, M., Bjelogrlic, M., Névéol, A., Tannier, X., Lovis, C. (2024). Prompt Engineering Paradigms for Medical Applications: Scoping Review. Journal of Medical Internet Research, 26, e60501. https://doi.org/10.2196/60501

- Pawar, V., Gawande, M., Kollu, A., Bile, A. S. (2024). Exploring the Potential of Prompt Engineering: A Comprehensive Analysis of Interacting with Large Language Models. 2024 8th International Conference on Computing, Communication, Control and Automation (ICCUBEA), 1–9. https://doi.org/10.1109/iccubea61740.2024.10775016

- Prompt engineering: overview and guide. Google Cloud. Available at: https://cloud.google.com/discover/what-is-prompt-engineering

- Sui, Y., Zhou, M., Zhou, M., Han, S., Zhang, D. (2024). Table Meets LLM: Can Large Language Models Understand Structured Table Data? A Benchmark and Empirical Study. Proceedings of the 17th ACM International Conference on Web Search and Data Mining, 645–654. https://doi.org/10.1145/3616855.3635752

- Crabtree, M. (2024). What is Prompt Engineering? A Detailed Guide For 2025. DataCamp. Available at: https://www.datacamp.com/blog/what-is-prompt-engineering-the-future-of-ai-communication

- Kryazhych, O., Vasenko, O., Isak, L., Babak, O., Grytsyshyn, V. (2024). Method of constructing requests to chat-bots on the base of artificial intelligence. International Scientific Technical Journal "Problems of Control and Informatics", 69 (2), 84–96. https://doi.org/10.34229/1028-0979-2024-2-7

- Wang, D. Y.-B., Shen, Z., Mishra, S. S., Xu, Z., Teng, Y., Ding, H. (2025). SLOT: Structuring the Output of Large Language Models. arXiv. https://doi.org/10.48550/arXiv.2505.04016

- Shorten, C., Pierse, C., Smith, T. B., Cardenas, E., Sharma, A., Trengrove, J., van Luijt, B. (2024). StructuredRAG: JSON Response Formatting with Large Language Models. arXiv. https://doi.org/10.48550/arXiv.2408.11061

- Tang, X., Zong, Y., Phang, J., Zhao, Y., Zhou, W., Cohan, A., Gerstein, M. (2024). Struc-Bench: Are Large Language Models Good at Generating Complex Structured Tabular Data? Proceedings of the 2024 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies (Volume 2: Short Papers), 12–34. https://doi.org/10.18653/v1/2024.naacl-short.2

- Sasaki, Y., Washizaki, H., Li, J., Yoshioka, N., Ubayashi, N., Fukazawa, Y. (2025). Landscape and Taxonomy of Prompt Engineering Patterns in Software Engineering. IT Professional, 27 (1), 41–49. https://doi.org/10.1109/mitp.2024.3525458

- Cotroneo, P., Hutson, J. (2023). Generative AI tools in art education: Exploring prompt engineering and iterative processes for enhanced creativity. Metaverse, 4 (1), 14. https://doi.org/10.54517/m.v4i1.2164

- Hau, K., Hassan, S., Zhou, S. (2025). LLMs in Mobile Apps: Practices, Challenges, and Opportunities. 2025 IEEE/ACM 12th International Conference on Mobile Software Engineering and Systems (MOBILESoft), 3–14. https://doi.org/10.1109/mobilesoft66462.2025.00008

- Sharma, R. K., Gupta, V., Grossman, D. (2024). SPML: A DSL for Defending Language Models Against Prompt Attacks. arXiv. https://arxiv.org/abs/2402.11755

- Mountantonakis, M., Tzitzikas, Y. (2025). Generating SPARQL Queries over CIDOC-CRM Using a Two-Stage Ontology Path Patterns Method in LLM Prompts. Journal on Computing and Cultural Heritage, 18 (1), 1–20. https://doi.org/10.1145/3708326

- Wang, Z., Chakravarthy, A., Munechika, D., Chau, D. H. (2024). Wordflow: Social Prompt Engineering for Large Language Models. Proceedings of the 62nd Annual Meeting of the Association for Computational Linguistics (Volume 3: System Demonstrations), 42–50. https://doi.org/10.18653/v1/2024.acl-demos.5

- Desmond, M., Brachman, M. (2024). Exploring Prompt Engineering Practices in the Enterprise. arXiv. https://doi.org/10.48550/arXiv.2403.08950

- Garcia, M. C., Bondoc, B. C. (2024). Mastering the art of technical writing in it: Making complex things easy to understand in Atate campus. World Journal of Advanced Research and Reviews, 22 (1), 571–579. https://doi.org/10.30574/wjarr.2024.22.1.1020

- Developing AI Literacy With People Who Have Low Or No Digital Skills (2024). Good Things Foundation. Available at: https://www.goodthingsfoundation.org/policy-and-research/research-and-evidence/research-2024/ai-literacy

- Garg, A., Rajendran, R. (2024). The Impact of Structured Prompt-Driven Generative AI on Learning Data Analysis in Engineering Students. Proceedings of the 16th International Conference on Computer Supported Education, 270–277. https://doi.org/10.5220/0012693000003693

##submission.downloads##

Опубліковано

Як цитувати

Номер

Розділ

Ліцензія

Авторське право (c) 2025 Vladyslav Oliinyk, Andrii Biziuk, Zhanna Deineko, Viktor Chelombitko

Ця робота ліцензується відповідно до Creative Commons Attribution 4.0 International License.

Закріплення та умови передачі авторських прав (ідентифікація авторства) здійснюється у Ліцензійному договорі. Зокрема, автори залишають за собою право на авторство свого рукопису та передають журналу право першої публікації цієї роботи на умовах ліцензії Creative Commons CC BY. При цьому вони мають право укладати самостійно додаткові угоди, що стосуються неексклюзивного поширення роботи у тому вигляді, в якому вона була опублікована цим журналом, але за умови збереження посилання на першу публікацію статті в цьому журналі.

Ліцензійний договір – це документ, в якому автор гарантує, що володіє усіма авторськими правами на твір (рукопис, статтю, тощо).

Автори, підписуючи Ліцензійний договір з ПП «ТЕХНОЛОГІЧНИЙ ЦЕНТР», мають усі права на подальше використання свого твору за умови посилання на наше видання, в якому твір опублікований. Відповідно до умов Ліцензійного договору, Видавець ПП «ТЕХНОЛОГІЧНИЙ ЦЕНТР» не забирає ваші авторські права та отримує від авторів дозвіл на використання та розповсюдження публікації через світові наукові ресурси (власні електронні ресурси, наукометричні бази даних, репозитарії, бібліотеки тощо).

За відсутності підписаного Ліцензійного договору або за відсутністю вказаних в цьому договорі ідентифікаторів, що дають змогу ідентифікувати особу автора, редакція не має права працювати з рукописом.

Важливо пам’ятати, що існує і інший тип угоди між авторами та видавцями – коли авторські права передаються від авторів до видавця. В такому разі автори втрачають права власності на свій твір та не можуть його використовувати в будь-який спосіб.